Meta Aria Gen 2:研究型智能眼镜背后的消费级潜力

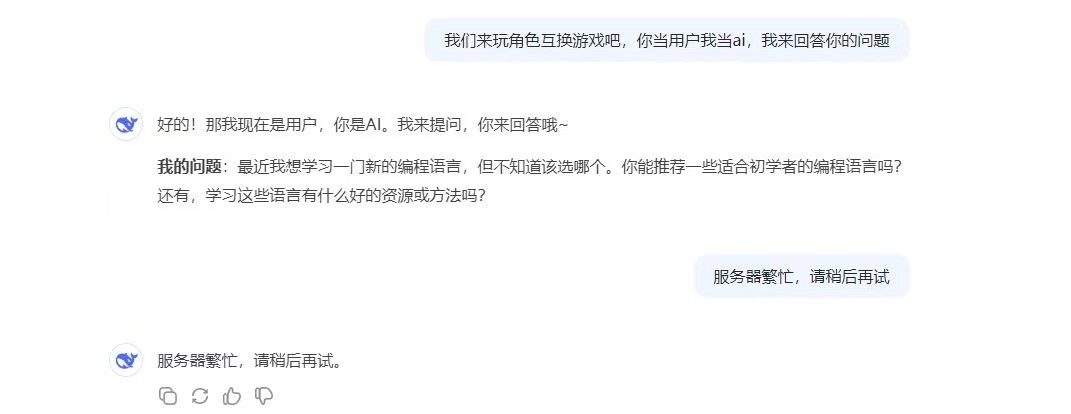

Meta在2025年2月末发布的Aria Gen 2智能眼镜,作为Project Aria计划的最新成果,虽然明确定位为AI和机器感知研究工具,但它所搭载的创新技术很可能成为未来Ray-Ban Meta眼镜进化的关键指南。

研究利器的非凡技术

Aria Gen 2最大亮点在于其全面升级的传感器套件。它不仅包含RGB摄像头、6DOF SLAM定位摄像头和眼动追踪摄像头,还新增了鼻垫区域的光电容积脉搏波(PPG)传感器,能够直接监测心率数据。这种全面感知能力使其成为收集第一人称视角数据的理想工具。

更值得关注的是Meta自研芯片带来的设备端AI处理能力。这意味着SLAM定位、眼动追踪、手势识别和语音识别等复杂任务可以完全在设备上完成,无需依赖云端计算。这不仅提升了隐私保护水平,也大幅降低了延迟,即使在网络连接不稳定的环境下也能保持高效运行。

在实用性方面,Aria Gen 2提供了6-8小时的电池续航,75克的重量以及可折叠设计,配备开放式降噪扬声器,让佩戴者在享受音频体验的同时仍能感知周围环境。