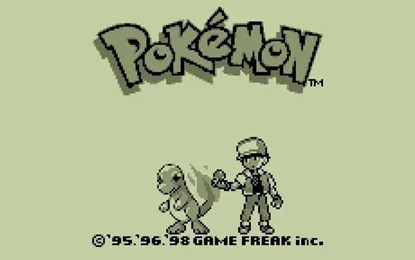

当我看到AI玩宝可梦时:技术与怀旧的奇妙交织

回想一下GBA游戏的黄金时代 - 你在深夜宿舍的台灯下,黑白屏幕的微光照亮你疲惫又兴奋的脸,不知不觉又打通了一个道馆,明明说好只玩十分钟的… 只是现在你已经不记得到底这款游戏的名字应该是宝可梦、口袋妖怪、神奇宝贝还是宠物小精灵了…

而现在:一个AI正在玩着同样的游戏,也在挑战同样的道馆,甚至给自己的杰尼龟起了个拼写错误但意外可爱的名字”TSUNMAI!”(大概是想拼tsunami/海啸来反映水系宝可梦的特性,但是AI也会有“手抖”拼写错误的时候?)。

当我在社交媒体上看到Google CEO Sundar Pichai宣布旗下的最强AI - Gemini 2.5 Pro成功通关《宝可梦蓝》的消息时,内心泛起的不仅是对技术的惊叹,更是一种奇特的情感混合物- 我们当年玩的游戏,现在竟然成了评估顶尖AI能力的标杆?

这不能不说是条神奇的时间线…

AI转战宝可梦:不只是”玩游戏”那么简单

2025年的AI世界有了两位新晋宝可梦训练师:Google的Gemini 2.5 Pro模型和Anthropic的Claude 3.7 Sonnet模型。