你的网站对 AI 可见吗?80%的网站存在严重可见性缺陷

当流量来源悄然改变

根据最新Adobe发布的2025年9月一组数据:美国零售网站来自AI来源的流量同比激增了1,100%。而且,这些通过ChatGPT、Claude、Perplexity等AI工具进入网站的访问者,表现出了比传统渠道更高的商业价值:参与度提升12%,转化率提高5%。

这意味着什么?当你的潜在客户在ChatGPT里询问”适合敏感肌的护肤品推荐”或”性价比高的露营装备”时,如果AI看不到你的网站内容,你就彻底失去了这个客户。不是排名靠后,而是压根不存在。

而我最近用一个免费工具测试了几位朋友的网站后发现:大部分网站并没有为这个新时代做好准备。

80%的企业存在严重可见性缺陷

Adobe刚刚推出了一款名为LLM Optimizer的产品,根据其发现:80%的企业网站存在严重的内容可见性缺陷,导致AI无法访问关键的产品信息或评论。这不是技术问题,而是一个时代错位的问题:我们的网站优化策略还停留在为Google、百度这样的传统搜索引擎服务的时代,而AI代理的内容抓取方式完全不同。

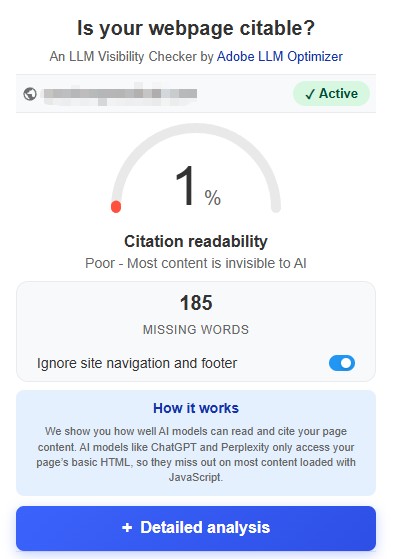

好消息是,这次Adobe同时推出了一个完全免费的Chrome插件”Is Your Webpage Citable?“,让任何人都可以在一秒钟内看到自己网站在AI眼中的真实模样。这个插件不需要注册、不需要付费、不需要任何配置,安装后点击任何网页就能得到三个关键信息:

- 引用可读性评分(Citation Readability Score):直接告诉你这个页面有多少百分比的内容是AI可以读取的;

- 对比视图(Agent vs. Human View):并排展示人类用户看到的页面 vs. AI代理看到的页面;

- 内容增益估算(Content Gain):如果使用预渲染技术,可以为AI恢复多少隐藏内容;

实测:问题比想象的严重

我用这个插件测试了几个朋友运营的跨境电商网站,结果让我颇为意外。

案例一:只有1%可见的精品站

某个专注北美市场的智能产品官网,视觉设计精美,人类访问体验很好,但插件显示AI可读性只有1%,也就是说这个网站对于AI来说几乎是空白的…

查看源代码后发现了问题所在:

1 | <!-- 站点已开启网站加速功能 |

这个所谓的”网站加速功能”确实优化了传统搜索引擎的抓取(它声称能识别百度、谷歌、Bing等爬虫的User-Agent),但问题是:AI代理使用的爬虫(如GPTBot、ClaudeBot、PerplexityBot)根本不在这个白名单里。结果就是,当ChatGPT想要引用这个网站的产品信息时,看到的只是一堆压缩后的乱码。

案例二:图片至上的视觉陷阱

另一个站的问题更典型:整个首页基本就是一张精心设计的大图,所有的产品卖点、促销信息、品牌故事都以文字形式印在图片上。对人类访问者来说,视觉冲击力确实很强。但对AI来说?因为AI爬虫还无法读取图片中的文字内容(除非你为每张图片都添加了详尽的alt文本,但这个站显然没有)。

为什么会出现这些问题?

这些问题的根源在于技术演进的时间差。过去十年里,我们学会了针对Google的算法优化网站:

- 使用CDN和缓存加速页面加载

- 采用懒加载减少初始加载时间

- 使用JavaScript框架构建单页应用提升交互体验

- 为传统搜索引擎爬虫设置特定规则

这些优化在SEO时代是最佳实践。但AI爬虫的工作方式完全不同:

传统搜索引擎爬虫:

- 有明确的User-Agent标识(Googlebot、Bingbot等)

- 通常会执行JavaScript

- 主要关注链接结构和关键词

- 给网站时间渲染动态内容

AI爬虫(LLM Bots):

- User-Agent各不相同且在快速迭代

- 很多不执行JavaScript(出于速度和成本考虑)

- 需要直接可读的结构化内容

- 对客户端渲染的内容完全盲目

这就是为什么一个SEO表现优秀的网站,在AI可见性上可能彻底翻车。

GEO不是取代SEO,而是新的必修课

Adobe将这种针对AI的优化称为GEO(Generative Engine Optimization,生成式引擎优化),以区别于传统的SEO。但需要明确的是:GEO并非要取代SEO,而是两者需要并行。

让我们看看两者的关键差异:

| 优化维度 | 传统SEO | GEO/AEO |

|---|---|---|

| 目标读者 | 搜索引擎爬虫 | AI代理和LLM |

| 内容呈现 | 可以依赖JavaScript渲染 | 需要服务端直接输出HTML |

| 结构化程度 | 关键词和元标签 | FAQ、清晰的段落、结构化数据 |

| 内容风格 | SEO优化文案 | 对话式、问答式内容 |

| 技术要求 | 允许特定爬虫 | 不能拦截AI爬虫 |

| 成功指标 | 排名、点击率 | 被引用频率、准确性 |

值得注意的是,Adobe自己也在实践这套方法。他们在Adobe官网上测试LLM优化后,Firefly产品页面在一周内被LLM引用的次数增加了5倍,Acrobat页面的可见性提升了200%。他们采取的优化策略并不复杂,主要集中在三个方向:

- Earned Media(赢得媒体):确保行业媒体和技术出版物的Adobe相关内容能被AI抓取;

- Social Media(社交媒体):维护在社交平台上的权威性和讨论度;

- Owned Media(自有媒体):优化页面内容结构,确保AI可以轻松读取;

你可以立即行动的5个优化方向

基于实测经验和行业最佳实践,这里是一些可以立即实施的优化建议:

1. 诊断现状

安装Adobe的免费Chrome插件,检查你的关键页面:

- 产品详情页

- 分类页面

- 关于我们/品牌故事

- FAQ页面

- 博客文章

如果可读性评分低于90%,请安排重点优化。

2. 检查爬虫访问权限

查看你的robots.txt文件和网站加速/安全设置,确保没有屏蔽这些AI爬虫:

- GPTBot (OpenAI)

- ClaudeBot (Anthropic)

- Google-Extended (Google Gemini)

- PerplexityBot (Perplexity)

- Amazonbot (Amazon)

如果你的网站使用了Cloudflare或其他CDN的”机器人防护”功能,需要将这些爬虫加入白名单。

3. 减少对客户端渲染的依赖

如果你的网站是React、Vue或Angular构建的单页应用,考虑实施:

- 服务端渲染(SSR)或静态站点生成(SSG)

- 预渲染关键页面

- 确保核心内容在HTML中直接可见,而不是完全依赖JavaScript加载

对于Shopify、WordPress等平台用户,检查主题是否过度使用JavaScript动态加载产品信息。

4. 优化内容结构

AI偏好清晰、结构化的内容(其实这些原则对于人类也适用):

- 使用明确的标题层级(H1、H2、H3)

- 创建FAQ部分,直接回答用户可能问AI的问题

- 避免将关键信息放在图片中(或至少添加详细的alt文本)

- 保持段落简洁(3-5句话为佳)

- 使用列表和要点使内容易于扫描

5. 添加结构化数据

使用Schema标记为AI提供清晰的上下文:

- Product schema(产品信息)

- Review schema(评价)

- FAQPage schema(常见问题)

- Organization schema(公司信息)

- BreadcrumbList schema(面包屑导航)

这些结构化数据不仅帮助传统搜索引擎,也让AI更容易理解和引用你的内容。

更大的转变正在发生

Adobe LLM Optimizer的企业版产品提供了更全面的功能:监测品牌在不同AI平台的可见度、与竞争对手对比、自动化优化建议、业务价值归因等。但对大多数跨境电商卖家和中小企业来说,那个免费的Chrome插件已经足够作为诊断起点。

真正重要的不是工具本身,而是意识到一个根本性的转变:我们正在从”搜索时代”进入”询问时代”。用户不再在搜索框输入关键词然后浏览十个蓝色链接,而是直接向AI提出问题并期待获得综合答案。在这个答案的形成过程中,你的品牌要么被看见和引用,要么根本不存在。

80%的消费者已经在使用AI进行至少40%的搜索决策。这个比例还在快速上升。现在开始优化,还不算晚。但如果等到竞争对手都已经在AI回答中占据位置时再行动,追赶的难度会大得多。

毕竟,在AI时代,不可见就等于不存在。

相关资源:

- Adobe LLM Optimizer Chrome插件(免费)

- 我之前关于AEO/GEO的文章:意图经济时代营销人员生存指南

- AEO:如何让ChatGPT推荐你的产品