连续74次生成同一张图后,ChatGPT画风彻底变了?一次“图像漂移”实验背后的真相

引言:从“复制粘贴”到“失控变形”,AI到底听不听话?

最近,一则关于ChatGPT图像生成功能的实验在AI圈中火了。一位名为papayathreesome的用户做了一个非常“轴”的测试:让ChatGPT 连续 74 次生成同一张人物图像,每次都强调“请原样复制,不要改动任何细节”。

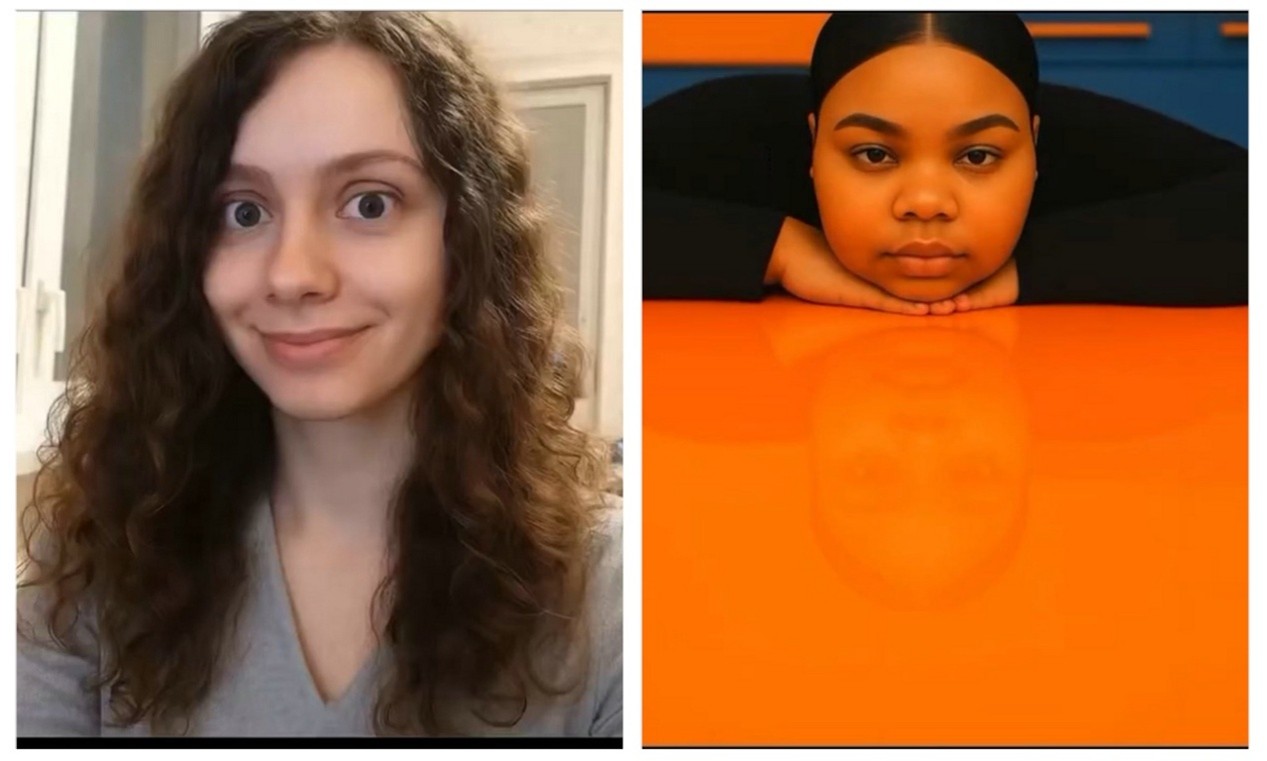

但结果却让人大跌眼镜 - 从最开始原图的一位长卷发白肤女孩,最后竟然演化成了一个肤色深、穿着不同、环境抽象的陌生人…

这背后的问题,真的只是 AI“不听话”吗?还是说,AI 本身就做不到“原样复制”这件事?这背后其实暴露了当前生成式AI在图像一致性上的几大关键问题 - 包括扩散模型的原理、AI会话上下文的残留影响,以及模型训练数据中的偏差如何逐渐显现。

下面我们来尝试拆解一下:ChatGPT到底是如何从左图跑偏到右图的…

01 | “每次都是重新画”的扩散模型,天生就不能“复印”

首先要搞清楚的是,目前的图像生成模型本质上是一个扩散模型(Diffusion Model)。

这种模型并不是“照搬”已有图像的像素,而是通过“先加噪声,再去噪”的方式,从随机噪声中重建图像。每一次生成,都会从不同的初始随机状态出发,即使提示词完全一致,也不会产生一模一样的结果。

这就好比你让不同的画家听着同一段描述来画画,他们也无法画出一模一样的作品。AI 正是这样一位“概率性画家”。

所以,哪怕你说了74次“请完全一样”,模型依旧只能“尽力而为” - 这是物理意义上的“无法复制”,而非模型“偷懒”或者“不听话”。

02 | 上下文污染:一次对话越用越“跑偏”

除了扩散模型的“非复制性”,还有一个被许多用户忽视的因素:AI的对话上下文机制。

ChatGPT是为对话设计的,它会记住你上一次说的话、它自己说的话、生成了什么内容……然后用这些“上下文”影响下一轮的回答。

这对于聊天很有帮助,但在图像生成中却可能引发严重副作用:一次次图像迭代,其实都被前一次的图像影响了。

于是你以为你在说“请跟第一张一模一样”,但 ChatGPT 可能理解成“请继续沿着上次的风格小幅修改”,久而久之便走样了。这也解释了为什么网友们观察到“最初几轮变得很快,后面变化变慢了” - 模型在上下文积累后,朝着某个“稳定态”收敛,哪怕那个状态和你一开始要的完全不一样。

关于上下文污染的影响,我在另一篇文章里也写过类似现象(尤其在文字生成中表现得更明显):

👉 从ChatGPT的“迷惑行为”说起:大语言模型自回归特性科普

在那篇文章中我总结了一条非常实用的经验:“当AI的回答开始变得怪异时,重新开始对话可能是最好的解法。”

这个原则在图像生成中也同样成立:每次要精准生成时,建议开启一个新的对话窗口,避免上下文污染影响输出。

03 | 训练数据偏差:为什么最后变成“政治正确的泥浆”?

这场实验最后还引发了更具争议的一点:为什么人物在多次迭代之后逐渐呈现出某种特定审美?

比如用户评论中提到,人物性别模糊、肤色发生变化、穿着变得更“非主流”,甚至出现所谓“woke sludge”(觉醒泥浆)的视觉倾向。

这背后很可能其实是另一个老问题:训练数据偏差。

生成式模型学习的是它看到过的数据分布。如果训练数据中某类人群、穿着或风格被过度代表,那么随着迭代次数增加,模型会“倾向于”朝这些高频样本靠近 - 这就像你在不断画图,每次都加一点常见元素,最终整幅图变得“熟悉但陌生”。

04 | 应用启示:AI图像生成不能做的几件事

这个实验为我们揭示了几个关键限制,特别值得创作者和开发者注意:

- 不能期望AI精确还原原图或人物设计 - 如果你是做角色形象一致性、品牌视觉管理的,请别指望只靠重复prompt就能维持风格完全一致;

- 图像迭代编辑建议每次新开对话窗口 - 否则会“越改越离谱”,你看到的可能是上一次图像残影叠加后的版本;

- 对抗模型偏差要靠提示词精细化和样本管理,而不是“靠运气”。

结语:AI 不“变脸”,你得先“重开”

这次74次复制图像“失败”的实验,其实不是Bug,而是扩散模型、上下文机制和数据偏差三者共同作用下的正常行为。

不过,也正因为如此,才让我们更加理解这些 AI 工具的工作原理和边界。而且请记住:

很多时候,真正的创造力,不是来自连续修改,而是来自一个新的开始。