AI文本检测的困境:当技术偏见遇上教育公平

当三分之二的教师都依赖AI检测工具时,我们失去了什么?

在ChatGPT掀起的AI革命中,教育界似乎找到了一个看似完美的解决方案:AI文本检测工具。然而,当我们深入探讨这些工具的实际应用效果时,一系列令人忧虑的问题逐渐浮出水面。这些问题不仅关乎技术的准确性,更涉及教育公平的根本。

近日,彭博(Bloomberg)发布了一篇深度报道,揭示了AI检测工具在教育领域应用的诸多隐忧。据统计,有三分之二的教师表示经常使用AI生成内容检测工具。在如此大规模的应用中,即便是极小的错误率也可能导致大量误判案例,进而造成严重的教育公平问题。

看似完美的解决方案背后

24岁的大学生Moira Olmsted的经历,深刻揭示了这个问题的严重性。作为一名自闭症谱系障碍者,她在重返校园后遭遇了一个意想不到的困境:她那结构严谨、逻辑清晰的个人写作风格,竟然让她的作业被AI检测工具错误标记为”人工智能生成”,被老师打了个零分。这不仅是对她个人努力的否定,更暴露出了AI检测工具在实际应用中的深层次问题。

技术偏见:一个不容忽视的现实

这些AI文本检测工具都宣传自己是“几乎”100%准确的,但根据Bloomberg实际找了500份2022年的大学申请essay来测试的结果,其中有1-2%会被误判为AI写作。而且更严重的是,研究表明,某些群体更容易成为这种技术偏见的受害者:

- 像Olmsted一样的神经多样性个体(指在思维、学习和行为方式上与典型发展不同的人)

- 英语作为第二语言(ESL)的学习者

- 习惯使用更直白词汇和结构化写作风格的学生

斯坦福大学研究人员在2023年的研究中发现了一个令人震惊的现实:虽然AI检测器在检查美国本土八年级学生所写文章时表现”几乎完美”,但同样的检测器却将超过一半非英语母语学生的文章错误地标记为AI生成。这种系统性的偏见正在教育领域制造新的不平等。

AI检测工具的技术迷思

要理解这些误判的根源,我们需要深入了解AI检测工具的核心技术原理。这些工具主要依靠两个关键指标来判断文本是否由AI生成:

- “困惑度”(Perplexity)分析 - 评估文本用词的复杂度和多样性。检测系统认为,AI生成的内容往往倾向于使用更安全、更通用的表达方式,因此具有较低的困惑度值。然而,这种判断标准恰恰可能会误伤那些写作风格严谨、逻辑清晰的学生;

- “突发性”(Burstiness)分析 - 测量文档中语言表达的变化程度。这个指标基于一个假设:人类写作通常在句子结构和用词选择上表现出较大的变化,而AI生成的内容则较为均匀稳定。但这种假设忽视了不同写作者的个人风格差异,特别是那些倾向于使用更规范化表达的群体;

技术对抗:一场没有赢家的军备竞赛

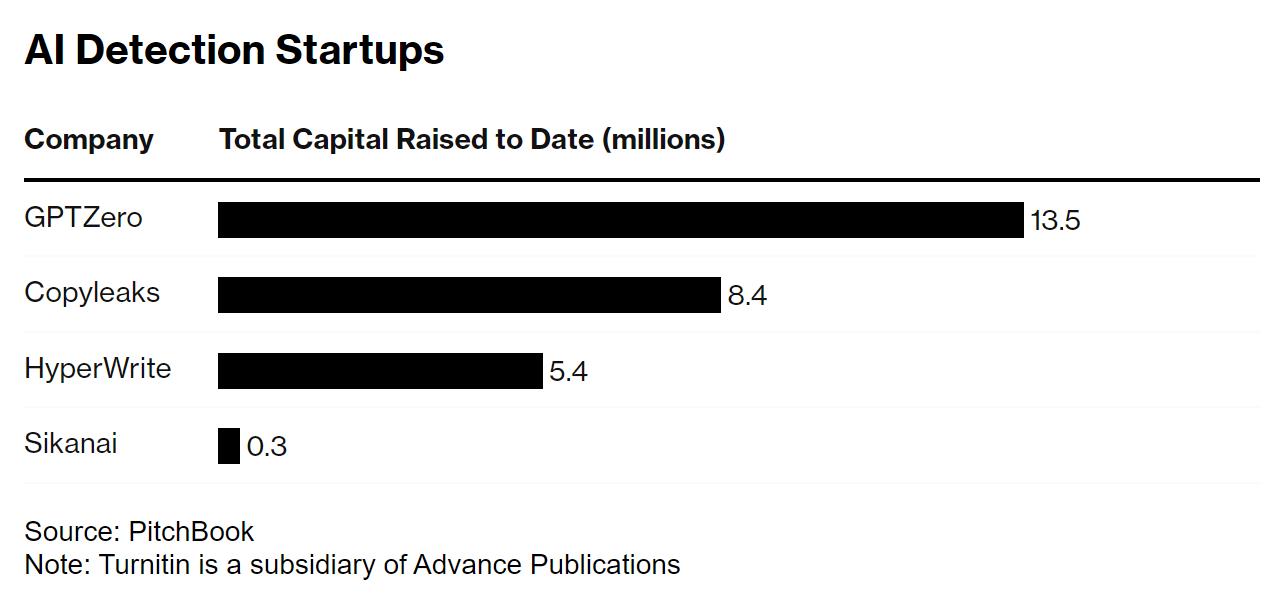

自2019年以来,AI检测初创公司已获得约2800万美元的投资,较知名的包括GPTZero、Copyleaks和Turnitin等。

然而,随着检测技术的发展,一种新的技术对抗正在形成——市场上出现了专门的”AI人性化”工具,声称能够帮助文本绕过AI检测。研究表明,只需在生成提示词中加入少量特定指令,就能让检测工具的成功识别率降至3%。这种技术军备竞赛不仅消耗了大量资源,更可能导致检测与反检测技术的无休止升级。

学习环境的异化:本末倒置的教育现状

在这种环境下,学生们不得不采取各种”自保”措施:有的开始录制整个写作过程的视频,有的则保存每一步的修改记录,甚至有学生因为担心被误判而放弃使用合法的写作辅助工具,如Grammarly(之前博客内容中也提出过这个问题 - 在GPT年代之前,使用Grammarly来辅助优化写作似乎并无太多老师反对,这里的界限应该划在哪儿?)。这种本末倒置的现象严重影响了正常的学习过程,也损害了师生之间的信任关系。

回归教育本质:重新思考AI时代的教育

在这场技术与教育的博弈中,我们似乎忘记了最重要的问题:教育的本质是什么?马里兰大学的Adam Lloyd教授提出了一个值得深思的观点:人工智能终将成为我们生活的一部分,与其将精力花在阻止学生使用AI上,不如思考如何将这项技术更好地融入教育过程中。

这个观点与可汗学院创始人萨尔曼·可汗在其新书中的主张不谋而合(我做过一个系列的翻译总结):我们需要重新思考AI时代的教育模式,将重点放在培养学生的创造力、批判性思维和问题解决能力上,而不是一味地试图遏制技术的使用。

原文:AI Detectors Falsely Accuse Students of Cheating—With Big Consequences