AI论文速读 - 大语言模型无法避免"幻觉",我们需要学会与之共存

这份名为《LLMs Will Always Hallucinate, and We Need to Live With This》的研究提出,语言模型中的“幻觉”不仅仅是偶尔发生的错误,而是这些系统无法避免的固有现象。我们通过数学分析来展示 - 幻觉的产生源自大语言模型的基本数学和逻辑结构,因此,仅通过改进架构、增强数据集或使用事实核查机制,无法彻底消除这些问题。

研究方法:

我们的分析借鉴了计算理论和哥德尔第一不完备性定理(该定理指出,在任何包含基本算术的一致形式系统中,总有一些真命题是无法在系统内部证明的)。我们特别关注了一些经典的“不可判定问题”,即那些无法通过算法彻底解决的问题,例如:

- 停机问题:判断一个程序是否会在有限时间内终止;

- 空问题:判断某个语言的集合是否为空;

- 接受问题:判断一个图灵机是否会接受某个特定输入。

研究发现:

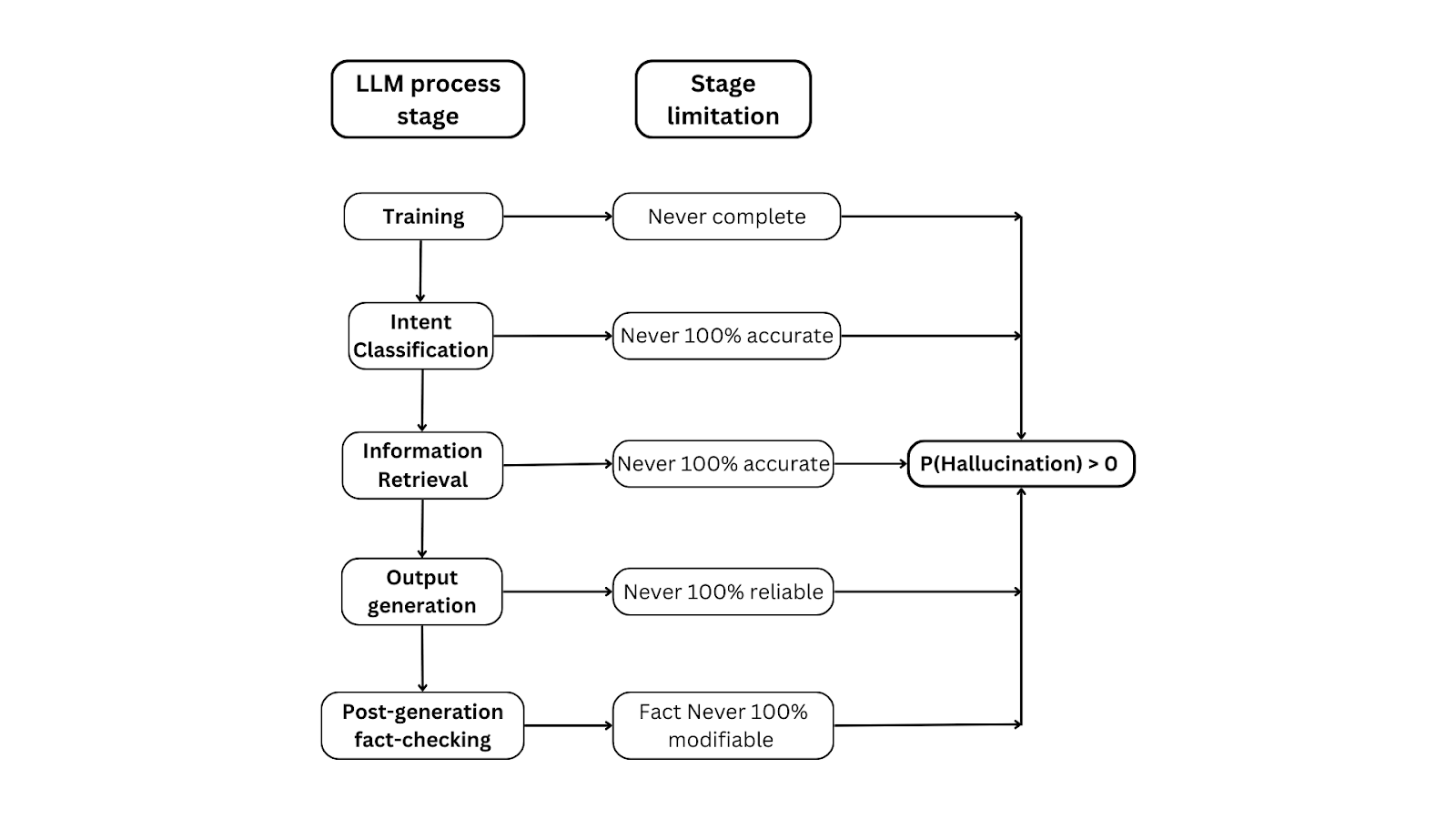

我们发现,在大语言模型的每个阶段,都存在不可避免的产生幻觉的可能性:

- 训练阶段:训练过程永远不可能100%完整,数据的多样性和复杂性使得模型无法完美地掌握所有信息;

- 意图分类:模型在理解用户意图时涉及不可判定的问题,无法确保每次都能正确判断用户的真实意图;

- 信息检索:信息检索过程无法保证100%准确性,尤其是当模型需要从大量数据中提取相关信息时,可能会出现错误或不一致;

- 文本生成:生成的输出文本必然会受到幻觉的影响,因为模型根据概率生成内容,无法完全避免虚构或不准确的信息;

- 事实核查:即使在生成后进行事实核查,检查机制也无法做到100%准确,并且总会存在一定的误差;

创新概念:

本研究提出了“结构性幻觉”这一新概念,指幻觉是这些系统内在的、不可避免的现象。通过数学分析,我们证明了幻觉的存在是必然的,从而挑战了“幻觉可以完全消除”的传统观念。这个概念对于理解和改进大语言模型的应用具有重要意义。