从Gartner的人工智能技术成熟度曲线来看当前大模型应用的困境和未来方向

昨天看了一篇名为《LLM应用路在何方?》的公众号文章,其中一个核心观点是“当面对即将收缩的市场时,任何低客单价的应用都面临着极大的出清压力”。虽然我不是特别同意他的整体逻辑链条,但这位作者确实提出了一个很有趣的思考视角 – 从【单次推理用户价值】减去【单次推理成本】的收益维度来解释为什么当前的大模型应用陷入一定困境。

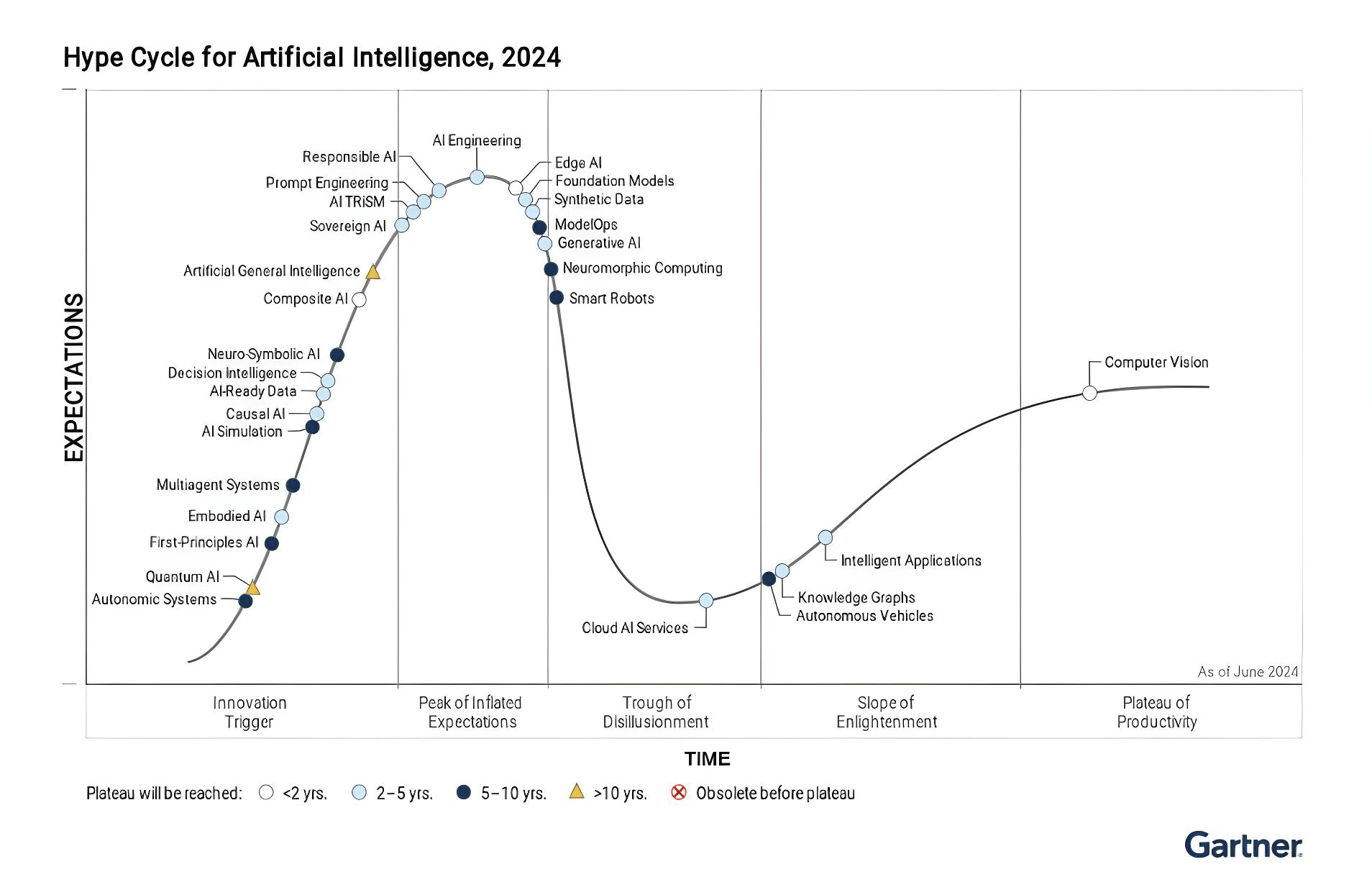

文中引用了一张来自Gartner的AI Hype Cycle 2023的图片来论证为什么目前生成式AI面临的是一个“即将收缩的市场”,我找了一张2024版本的,并附上一些核心总结,感觉对于理解当前这轮AI浪潮遇到的挑战和发展方向有一定帮助:

“技术成熟度曲线”(Hype Cycle)

这个来自Gartner的技术成熟度曲线描述了一项新技术从出现到被广泛接受的整个过程。其中Y轴代表期望值(Expectations),X轴体现时间和技术成熟度的不同阶段:

- 创新触发期(Innovation Trigger):新技术刚出现,期望开始上升;

- 期望膨胀的顶峰(Peak of Inflated Expectations):随着炒作和宣传,期望值迅速攀升至顶峰;

- 幻灭低谷(Trough of Disillusionment):当现实难以满足过高期望时,期望值迅速下降进入低谷;

- 启蒙爬升期(Slope of Enlightenment):随着人们对技术有了更务实的理解,期望值开始稳步上升;

- 生产力平台期(Plateau of Productivity):最终,技术成熟并被广泛接受,期望值趋于稳定;

AI Hype Cycle 2024核心观点

- 生成式AI和基座模型都已经越过了”期望膨胀的顶峰”(2023年),正在进入”幻灭低谷”阶段(2024年)。幻灭低谷阶段虽然伴随着挫折和挑战,但对于完善和优化技术至关重要。在这个阶段,人们会设定现实的期望,探索实际应用,并为更广泛的采用奠定基础。生成式AI和基座模型当前处于低谷阶段特征包括:

- 即使应用了RAG(检索增强生成)等方法,生成式AI/基座模型依然面临内容准确性方面的大量挑战[1];

- scaling和基础设施开发的困难;

- 将生成式AI错误应用于更适合传统AI的任务;

- 生成式AI解决方案尚未完全集成到现有生成流程中,以及易用性方面还有挑战;

- 但生成式AI的加速发展正在带动其他AI技术发展,导致许多AI相关技术在成熟度曲线上进展更快了;

- 计算机视觉(用于图像识别等)和知识图谱(用于组织和表示知识)是两个已经达到生产力平台期的 AI 技术示例;

- 跨不同 AI 模型(来自不同提供商)的无缝集成需求正在推动多智能体系统的加速发展。这些系统能够实现不同 AI 智能体之间的通信和互操作性,促进更顺畅的数据流动和协作;

- 神经形态计算受人脑结构启发,被提出作为解决 AI 能源需求的潜在方案。这些芯片在小型、节能的设计中提供高计算能力,使 AI 能够在各种设备和环境中部署;

- 不同AI技术达到平稳期的时间差异很大,有些预计在2-5年内达到成熟(例如生成式AI和基座模型),有些在5-10年内(例如智能机器人和多智能体系统),还有一些可能需要超过10年(例如AGI);

注1:大模型的幻觉问题很可能确实无法解决,具体可以参考这篇最新的论文。但“幻觉”其实可以看成是LLM的天然特性,因为正是靠幻想,LLM才能产生这些全新的文章。

同时,我们生活在一个由人类组成的世界中,而人类本身就经常出现”幻觉”。我们会犯错,会记错事情,这是人之常情。正因如此,我们的社会系统已经具有一定的”容错性”。所以综上我觉得没有必要对大模型幻觉过于苛刻