AI论文速读 - LLM幻觉问题仍严重,且将长期存在

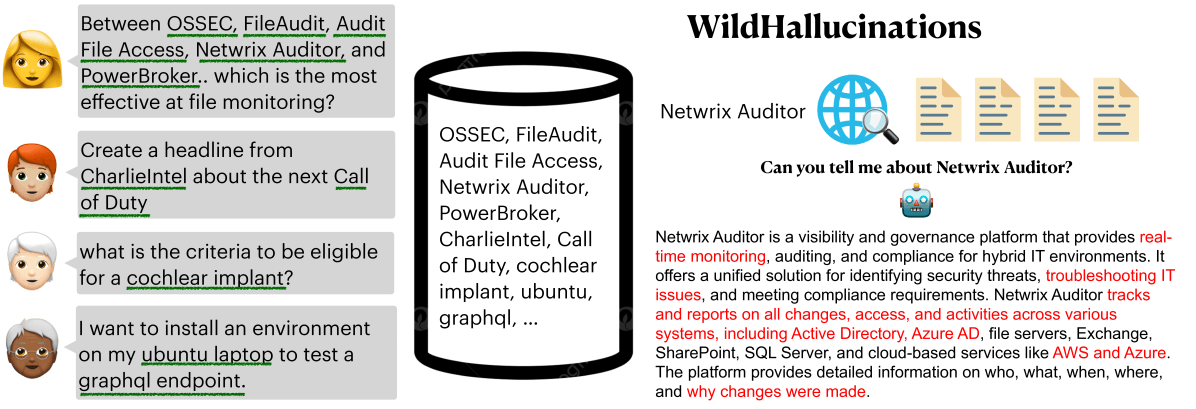

最近的一项研究对十多个流行的AI模型从幻觉问题方面进行了评估,引入了一套名为WildHallucinations事实性评估基准来更全面地涵盖多样化领域。

主要观点总结如下:

幻觉普遍存在:即使是最先进的模型,也只能在约35%的时间内生成完全无幻觉的文本!这意味着在使用AI生成的内容时,用户需要保持警惕并进行事实核查;

批注:“幻觉”其实可以看成是LLM的天然特性,因为正是靠幻想,LLM才能产生这些全新的文章,所以我也觉得没有必要对大模型幻觉过于苛刻。同时,正如最近看到的一段Aidan Gomez(Transformer作者之一)的采访所说 - “But we exist in a world with humans and humans hallucinate constantly. We get stuff wrong, we misremember things. And so we exist in a world that’s robust to error.”模型性能比较:

- OpenAI的模型在减少幻觉方面表现最佳,其次是Mixtral 8x22B、Command R和Perplexity的Sonar模型;

- 和大家猜测的不同,并非更新、更“聪明”的新模型在幻觉方面表现更好,GPT-4o和更早的GPT-3.5在基准测试中回答问题的事实正确率百分比大致相同;

- 同时,模型大小并不是决定因素。较小的模型(如Claude 3 Haiku)在幻觉频率上与更大的模型(如Claude 3 Opus)相当;

主题差异:

- 模型在回答有关地理和计算机科学的问题时表现最好;

- 名人和金融相关问题最容易导致幻觉;

- 这种差异可能与训练数据中各主题信息的丰富程度有关;

维基百科依赖:当答案来源不是维基百科时,所有模型的事实准确性都显著降低。这表明AI模型严重依赖维基百科的内容,可能影响它们在处理非常规或专业信息时的准确性;

搜索能力的局限性:即使是能够进行网络搜索的模型(如Command R和Sonar),在处理”非维基”问题时也遇到了困难。这说明仅仅增加搜索功能并不能完全解决幻觉问题;

长期挑战和数据质量问题:研究人员预计,幻觉问题将在相当长的一段时间内持续存在。尽管有各种减少幻觉的方法,但实际改进仍然有限。同时值得注意的是,即使是互联网上的信息也经常存在矛盾。这部分是因为人类创作的训练数据本身就可能包含错误或幻觉,进一步加剧了这个问题的复杂性;

论文原文:WildHallucinations: Evaluating Long-form Factuality in LLMs with Real-World Entity Queries