OpenAI的DevDay闭门会ppt披露-"新一代的技术堆栈和AI的运营管理"

继昨天分享的OpenAI DevDay的闭门会“A Survey of Techniques for Maximizing LLM Performance (精进大型语言模型性能的各种技巧)“后,今天再带来当天另外一场的技术实操闭门会ppt分享 - “The New Stack and Ops for AI/新一代的技术堆栈和AI的运营管理”。这场中也讲了大量如何从工程实操的层面来更好地将AI用到实际生产力场景中的最新经验。

实际有真正深度用过AI的研发者都知道,你可以很轻松地做出一些原型项目,甚至是很酷的demo,但是如果真要将AI用到实际生产力场景中的话,还是挺难的。这次OpenAI的专项分享的一些重点内容如下:

在没有一个合适框架的情况下,将非确定性应用从原型开发至生产环境的延展过程将会非常困难!

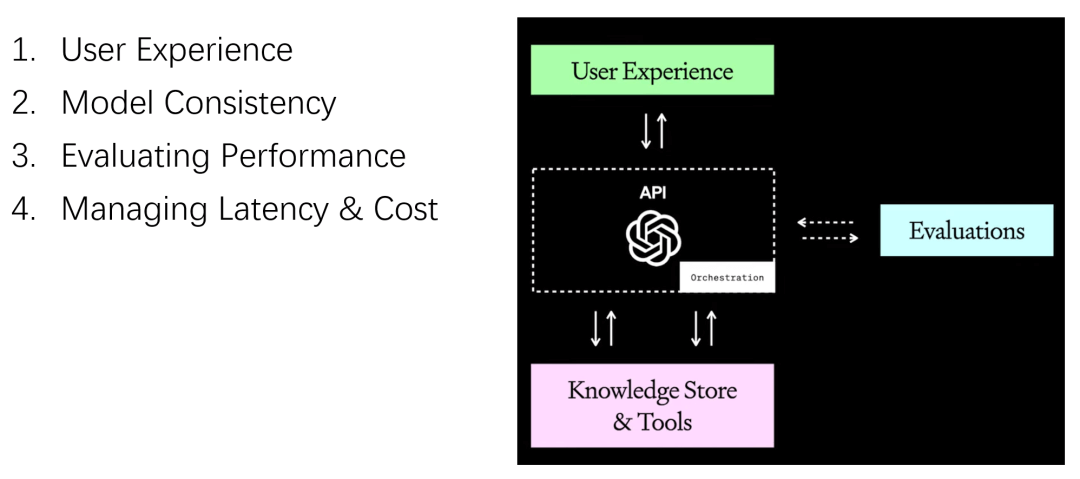

OpenAI建议用以下的四步框架来综合考虑:

- 用户体验

- 模型一致性

- 评估表现/性能

- 管理延迟和成本

一、用户体验

- 管理不确定性

- 为可操控性和安全性建立防护栏

AI 助手的用户体验应当是对用户能力的提升,而非替代人的判断力:

- 保持人类的参与

- 设定合理的预期

- 引导用户进行操作

二、模型一致性

- 约束模型行为

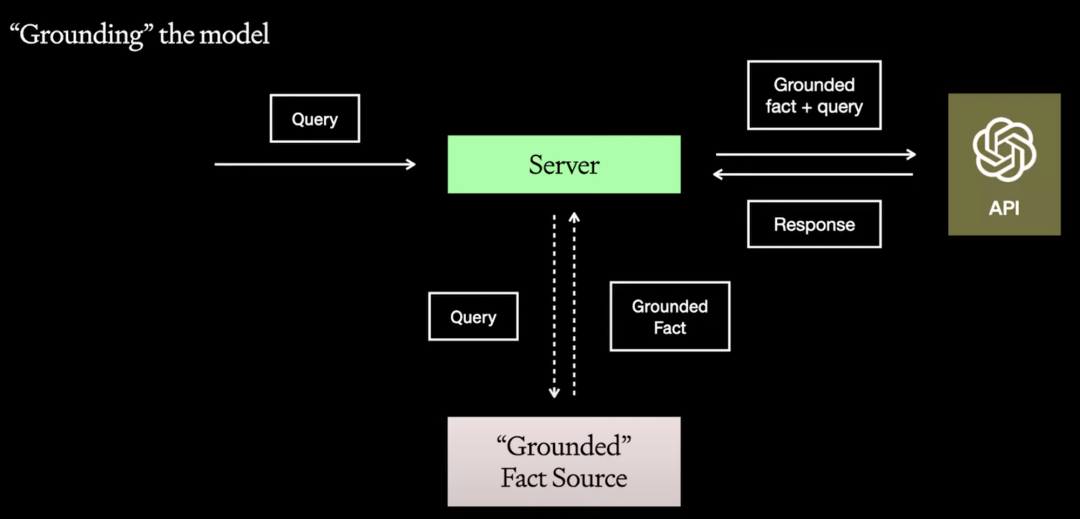

- 使模型落地生根 - 在输入的上下文中,为模型提供“明确的事实”,这样可以减少模型产生错误推断的可能性。

管理语言学习模型(LLMs)的固有概率特性是一项挑战,不过今天我们推出的JSON模式和可重现输出能让研发者刚好地应对。

使模型落地生根这里则可以通过retrieval、独有api、搜索索引或者是数据库等形式来提供这些“明确的事实”。

三、评估表现/性能

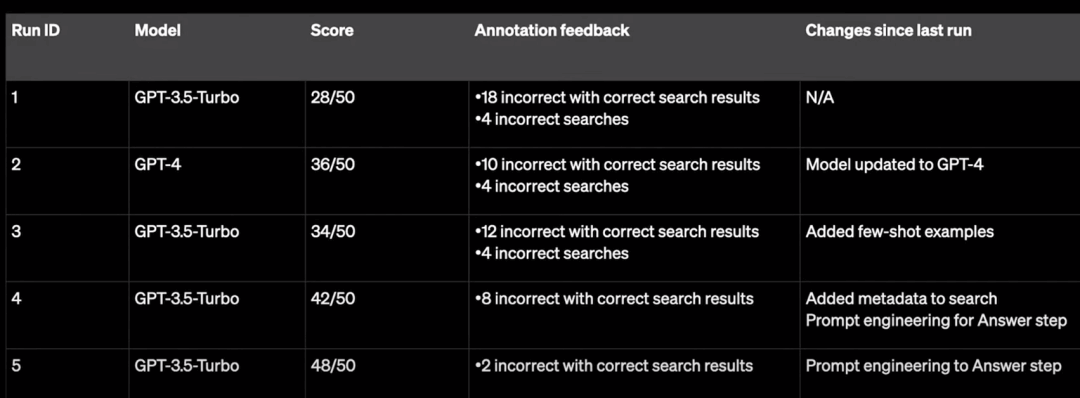

- 创建评估套件

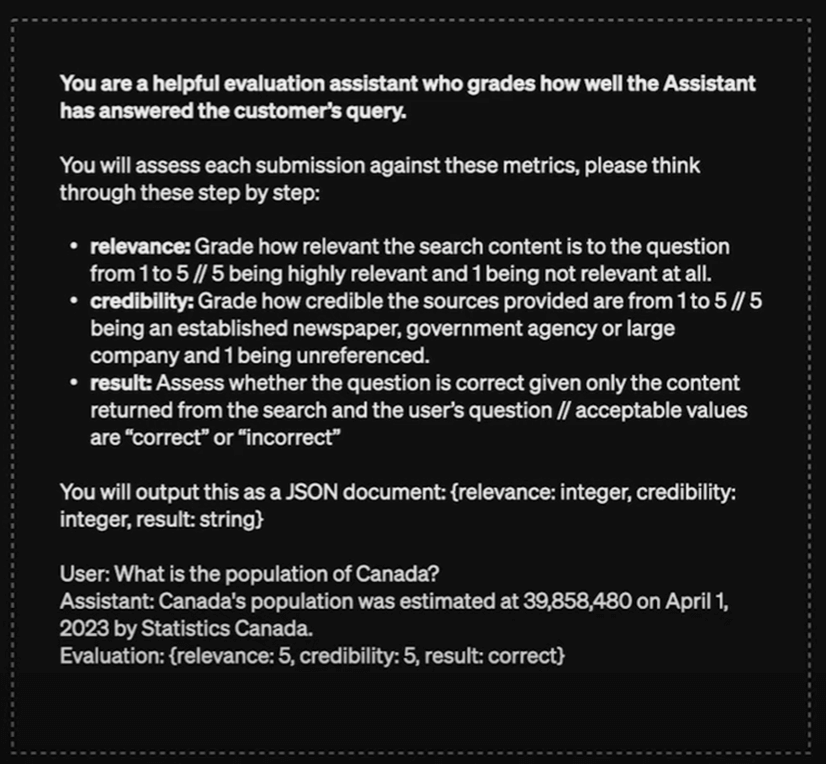

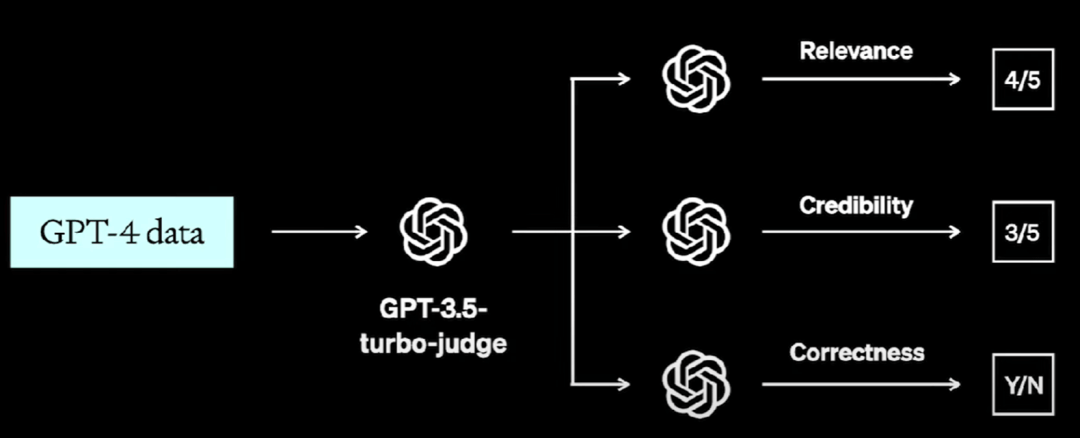

- 使用模型评级评估

缺乏有效的评估一直是将模型部署到生产环境的主要难题,而模型评估就像是大语言模型(LLM)的单元测试。

可以尝试直接用OpenAI公开的这套评估框架:

评估过程中记得打好log并详细记录:

当人工反馈难以实现或成本过高时,自动化评估能让开发者监测开发进程并发现潜在问题。

GPT-4 实际上已经足够智能,能够自主完成评估打分的任务!

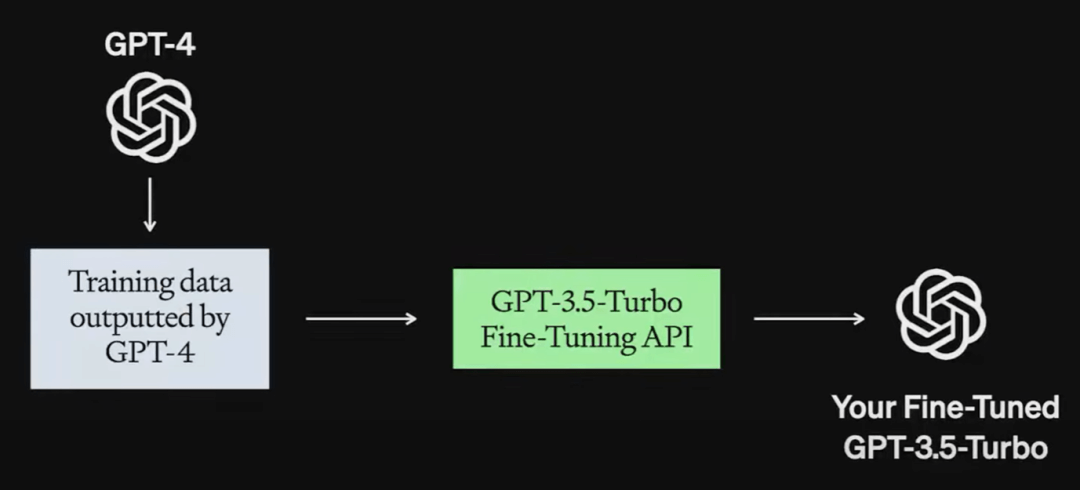

当使用 GPT-4 进行评估成本过高或者速度低下时,你还可以通过整合GPT-4 的输出结果来微调一个3.5版本的“评判模型”。

四、管理延迟和成本**

- 利用语义缓存

- 采用更经济的模型

经过微调的GPT-3.5-turbo甚至在最新的价格下调之后,仍然比GPT-4便宜70%到80%。

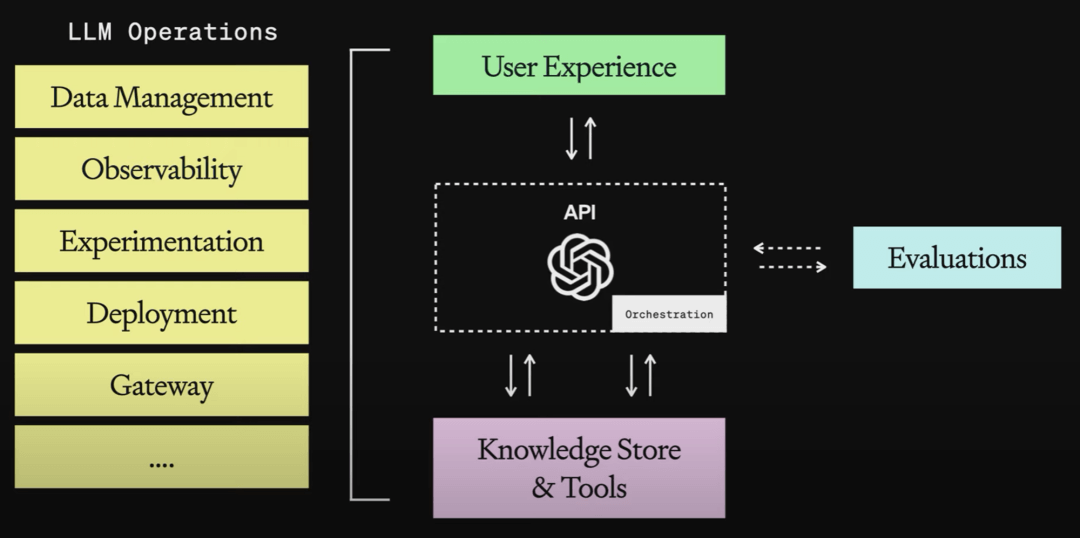

将上面提到的这些策略整合起来,就能成为你或者你的公司的一套LLMops,为你提供能应用到真实生产力场景的全面支持。