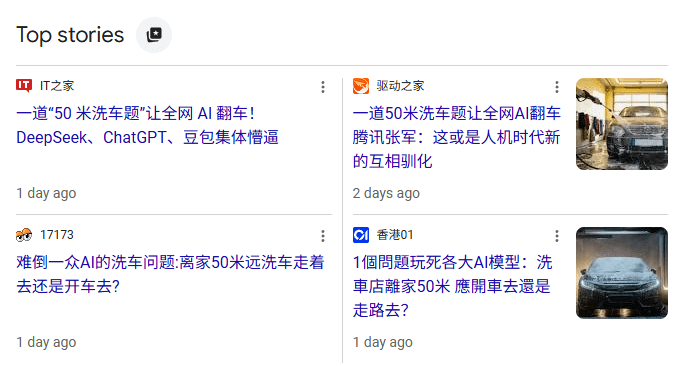

死神来了:当 Anthropic 把公司每个部门都「安排」了一遍

看到 Cowork 最新更新的 Plugin 目录页面,不禁想起港片里那句经典台词——

「一家人最紧要齐齐整整。」

只不过,站在 Thomson Reuters、Salesforce、IBM 这些公司的角度,这句话听起来更像死神拿着点名册在念。

打开 Plugin 页面:Sales(销售)、Marketing(市场)、Legal(法务)、Finance(财务)、HR(人力资源)、Engineering(研发)、Design(设计)、Operations(运营),再往下翻,还有 Investment Banking(投行)、Private Equity(私募)、Wealth Management(财富管理) 整套金融家族。

这是一张企业组织架构图,每一个格子里都有人在上班…

过去四周,华尔街用实际行动告诉我们这张图意味着什么:每次 Anthropic 往这张图里填一个新格子,对应行业的股票就跌一次。不是因为发布会有多华丽,不是因为产品演示多完美,仅仅是因为人们开始意识到:这个格子里的活,AI 也许真的能干,而且不需要给它发工资。

这是白领就业结构变化的第一个切实裁决。Axios 说得精准:「被广泛恐惧的白领就业大屠杀甚至还没有真正开始。」